ニュース

グーグルのAI祭り「Google I/O 2024」基調講演を総まとめ

2024年5月15日 08:17

GoogleフォトにGeminiを使った新機能「Ask Photos」を追加

Googleのスンダー・ピチャイCEOは基調講演の最初に、Geminiによってパワフルになった例として、Googleフォトの「Ask Photos」という新機能を挙げる。

この新機能は、Googleフォトのアプリに追加されるチャット形式のアシスタント。たとえば駐車場で自分のクルマのナンバーが思い出せないとき、ただ「ナンバープレート」と検索すると、すべてのナンバープレートが検索されてしまう。

しかしここで「自分のナンバープレートは?」と検索すれば、何度も登場するクルマのナンバープレートを検出し、その数値もテキストで表示してくれる。

思い出をまとめる機能にも使えて、たとえば「娘の水泳の上達を見せて」と聞けば、過去の写真から関連するものを数枚ピックアップし、サマリーとして表示させる。

このAsk Photos機能は、数ヶ月以内、今夏には提供を開始される。

Geminiはより長いコンテキストに対応

Geminiはさらに長いコンテキスト、何百ページものテキスト、何時間もの音声、1時間のビデオなども持ち込めるようになる。

そのためには100万トークンのコンテキストウィンドウが必要となるが、これが最新のGemini 1.5 Proで可能となっている。

Geminiの有料プランのGemini Advancedで、100万トークンが35の言語で利用可能になる。さらに200万トークンに拡大したバージョンが開発者向けのプライベートプレビューとして公開される。

200万トークンのGemini 1.5だと、2時間のビデオ、22時間のオーディオ、6万行以上のコード、140万単語のテキストを入力できるようになる。Googleによると、Gemini 1.0 Proは3.2万トークン、ライバルのGPT-4 Turboは12.8万トークン、Claude 3は20万トークンなので、文字通り桁違いだとアピールしている。

こうしたGeminiの機能は、エンドユーザーはGoogle Workspaceで利用できる。

たとえばGmail上では、子どもの学校から届いた最近のメールについて、添付されたPDFファイルも分析して要約するようなこともできる。また、参加できなかったGoogle Meetの1時間の会議録画からハイライトを抜き出すこともできる。保護者会からのボランティア募集メールがあれば、GeminiがGoogleカレンダーで日程が空いているかを自動で確認し、返信の下書きもする。

昨年2023年のGoogle I/Oで発表された生成AIを使った学習支援ツール「NotebookLM」にもGemini 1.5が導入される。複数の教材を取り込み、学習ガイドやFAQ、クイズを生成できる。これに加え、科学に関するディスカッションをするといった機能も可能になる。

Gemini 1.5 Proがロングコンテキスト化する一方で、低遅延と低コストを必要とするユースケース向けに、軽量なモデルの「Gemini 1.5 Flash」が発表された。こちらもPro同様に100万トークンが利用できる。

さらにこうした技術を使い日常生活に役立てる、将来のAIアシスタントのビジョンとして、「Project Astra」というものも公表された。デモンストレーション映像では、スマートフォンのカメラやスマートグラスが映したオフィス内の風景をリアルタイムで解析し、それを元にユーザーと対話したりといった模様が公開されている。

このデモンストレーションはプロトタイプだが、これら機能の一部は今年後半にはGeminiアプリなどに搭載される予定だ。

このほかにもオープンモデル「Gemma」の次世代版、「Gemma 2」も6月にリリースされると発表された。

静止画・音楽・動画の生成AIもアップデート

生成AIでは話題になりやすいクリエイティブ分野でもアップデートがなされる。

まず画像生成ではより精度の向上した新モデルの「Imagen 3」が発表された。より長いプロンプトから、詳細な記述もしっかりと取り込み、精度の高い画像を生成できる。

音楽の生成AIの「Music AI Sandbox」も登場する。デモンストレーション映像では、開発協力しているミュージシャンが、収録したギターフレーズをブラジル風に変換したり、ヴィオラのパートを追加したり、といったことを生成AIで行なっている。

動画の生成モデル「Veo」も発表された。こちらは画像生成モデルのように、プロンプトから1080Pのビデオを作成できる。単なる静止画の連続ではなく、被写体の一貫性を維持した動画が生成できるほか、カメラのパンや逆光などといった映画的な演出も再現できる。

これらの機能はlabs.googleで提供される。

https://blog.google/technology/ai/google-generative-ai-veo-imagen-3/#Imagen-3

クラウドサーバーは新TPU/GPUで強化

こうした機械学習コンピューティングの進化に伴い、その計算能力のニーズはさらに高まっている。そこでGoogleは第6世代のTPU「Trillium」を発表した。こちらはチップあたりの計算性能を4.7倍に向上させ、電力効率も向上させている。今年後半にはクラウドデータセンターにTrilliumが搭載される。

さらにNVIDIAが3月に発表した新GPUのBlackwellについても、来年前半にはGoogleのクラウドデータセンターに導入される。

クラウドデータセンターには液冷システムが導入され、その総設備容量は1ギガワット近くに達しているという。

Google検索には概要テキストが表示される「AI Overview」を追加

Googleのサービスの代表格でもあるGoogle検索も、Geminiによって新しいレベルに引き上げられ、ユーザーが尋ねたことに対し、「Googleがユーザーに代わってググってくれる」ようになる。

まず「AI Overviews」により、ユーザーの質問に対して概要(Overview)が表示される。

たとえば「布製ソファの掃除の仕方は」と検索すると、掃除機を使った方法や重曹を使った方法などの概要がテキストで示され、その下に詳細を解説するWebページ、必要な商品の販売リンク、従来通りの検索結果が表示される。この機能は同日より米国内で提供され。近日中には他国でも提供が開始される。

さらにマルチステップ推論機能により、複雑な質問にも対応するようになる。これによりたとえば1回の検索で「ボストンで最高のヨガ・ピラティススタジオを探し、紹介特典の詳細や移動経路を表示」といったことができるようになる。

マルチステップ推論機能の例として、旅行や食事のプランニングや3日分の食事メニューの作成といったデモンストレーションも示された。食事や旅行のプランニング機能はGoogleのSearch Labsで英語向けに提供され、今年後半にはパーティーやワークアウトなどのカテゴリも追加される。

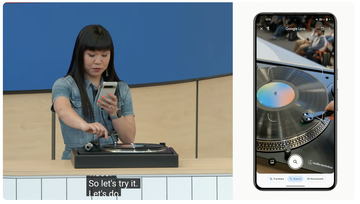

動画で検索できる機能も提供される。ステージ上で実施されたデモンストレーションでは、Google検索アプリで正常に動作しないレコードプレーヤーを撮影し、どうしてそうなるのかを音声で質問すると、AI Overviewが原因や対策を答える、という様子が示された。

この動画による検索は、近日中にGoogleのSearch Labsで英語向けに提供される。

GmailなどのGoogleアプリ群もGeminiが使いやすく連携

GmailやSheetsといったGoogle Workspaceアプリ群にもGeminiを使った新機能が導入される。

デスクトップ版の各アプリでGemini 1.5 Proを使うためのサイドパネル機能は、現在はWorkspace Labsなどで試験的に導入されているが、来月からGemini for WorkspaceアドオンやGoogle One AI Premiumプランを契約する一般ユーザーや企業向けアカウントで利用できるようになる。

GmailにはさまざまなGeminiを使った機能が導入される。まずさまざまな話題が交わされて長くなったメールのスレッドに対し、ワンタップで要約する機能が提供される。こちらも来月からGemini for WorkspaceアドオンやGoogle One AI Premiumプランを契約する一般ユーザーや企業向けアカウントで利用できるようになる。

さらにメールスレッドのコンテキストを理解した上でのスマート返信作成機能も提供される。こちらは7月からWorkspace Labsのユーザー向けに提供される。

デスクトップ版のサイドパネルのような「Gmail Q&A」という機能も提供される。Geminiアイコンをタップすると、表示中のメールやスレッドに対するアクションが提案され、さらに具体的に「修理業者からの見積もりを表示して」といったことをGeminiにお願いすることもできる。こちらも7月からWorkspace Labsで提供される。

Geminiを使った機能は、Workspaceアプリを横断して機能させられるようにもなる。

デモンストレーションでは、フリーランスのカメラマンがGmailで届いている領収書を閲覧するとき、サイドパネルに領収書を整理する提案がなされ、それを実行すると、クラウドドライブのフォルダに領収書をまとめ、その領収書から金額を抽出してスプレッドシートを作成し、さらにその内訳をビジュアル化する、といったことが行なわれた。

こうした機能は「AI workflows」や「Data Q&A」として開発中で、今年9月にはWorkspace Labsで利用可能になるという。

企業のWorkspaceでもGeminiが活躍できるようになる。デモンストレーションではグループにGeminiによるAIアシスタントに「Chip」と名付け、チャットに参加させて、コンテキストを理解した上で質問に答える様子などが示された。

このChipをチャット、ファイル、メールのスレッドに追加することで、Chipは記憶を構築し、それらの情報を統合して回答できるようになる。

こうしたGeminiによるバーチャルチームメイトについては、どのように実装するかなど多くの課題があるとしつつも、Googleでは期待していて欲しい、としている。

Geminiアプリには自然に会話できる「Gemini Live」などを追加

Geminiのアプリには今年の夏にはより自然な会話ができる「Gemini Live」が追加される。ユーザーについて深く理解し、その発話パターンに適応し、自然に答え、Geminiの応答中に割り込むこともできる。

さらにProject Astraで開発されている動画をリアルタイムに理解し、それにも反応できる機能も、今年後半にGeminiアプリに導入される。

好きなトピックに関するエキスパートを作れる「Gems」という機能も追加される。たとえばプログラミングのパートナー、ジム仲間、料理長など、何かに特化した人格を「Gem」として作成し、切り替えて利用できる。この機能は今後数ヶ月のうちに提供される予定。

AndroidをGoogle AIを体験できる最高の場所に

グーグルでは、AndroidのOSのコアにGoogle AIを搭載することで、Androidスマートフォンを真にスマートにしていく。

たとえば「かこって検索」の機能は、すでにPixelやGalaxyで利用できるが、これに学習支援機能が追加される。たとえば生徒が行き詰まっている問題をかこって検索すると、その解法のヒントが示される。今年後半にはかこって検索は数式やグラフなどにも対応する予定となっている。

AndroidではシステムレベルでGeminiが統合されることがポイントとなる。デモンストレーションではPixel 8aを使い、RCSメッセージのやりとりの中でGeminiに画像を生成してもらって送ったり、YouTube動画や長いPDF書類をGeminiに読ませて質問をしたり、といったことが示された。

さらに、Pixelのローカルプロセッサー上で動作する「Gemini Nano」で可能なことも広げていく。

たとえば弱視のユーザー向けに、送られてきた画像やWeb上の画像についてテキストで説明する、といった「TalkBack」機能が今年後半にアップデートで提供される。

同様にオンデバイスのAIを使った例として、詐欺対策も挙げる。詐欺のテキストメッセージや電話を受け取ったとき、その電話中に「詐欺の可能性が高い(Likely scam)」という警告が表示される。このときの処理はオンデバイスAIで処理されるので、サーバー側に情報が送信されず、個人情報に関わる事柄も安全に利用できるとしている。