みんなのケータイ

スマホでパワフルなAIを無料? で使い放題にする! オープンなAIモデルを扱える「LM Studio」を使ってみた

2025年12月15日 00:00

今やChatGPTとかGeminiとか、CopilotとかClaudeとか、いろいろなAIツール・アシスタントがあって、だいたい無料で使えたりもするけれど、ヘビーに使い始めると制限にぶち当たって往生してしまいがち。

有料会員になっても制限が全くないわけではないし、なんとなくクラウドやインターネットに流したくないヒミツのプロンプトをどうするか、という問題もある。

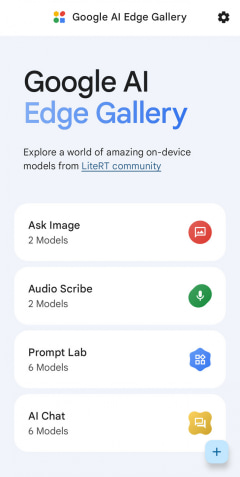

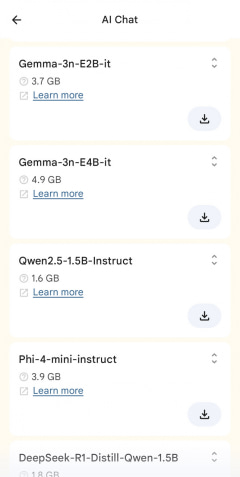

ならば、全部手元でAIを動かせばいいのではないだろうか。いわゆるローカルAIっていうやつだ。スマホ単体でローカルAIを実践するにあたっては、「Google AI Edge Gallery」という便利なアプリもあるけれど、さすがにスマホの限られたリソースだとできることも限られる。ワイはもっと賢いAIを使いたいんじゃ!

そこでふと思い付いたのが、今この文章を打っているパソコンを使えないだろうか、ってこと。そこそこのGPUを積んでいるので、そいつをうまくなんとかしてスマホから利用できるようにすれば、いい感じに賢いローカルAI環境をいつでもどこでも好きなだけ活用できるのでは?

で、ありがたいことに今の時代、そういうことを簡単に可能にするツール類がそのへんに転がっている。

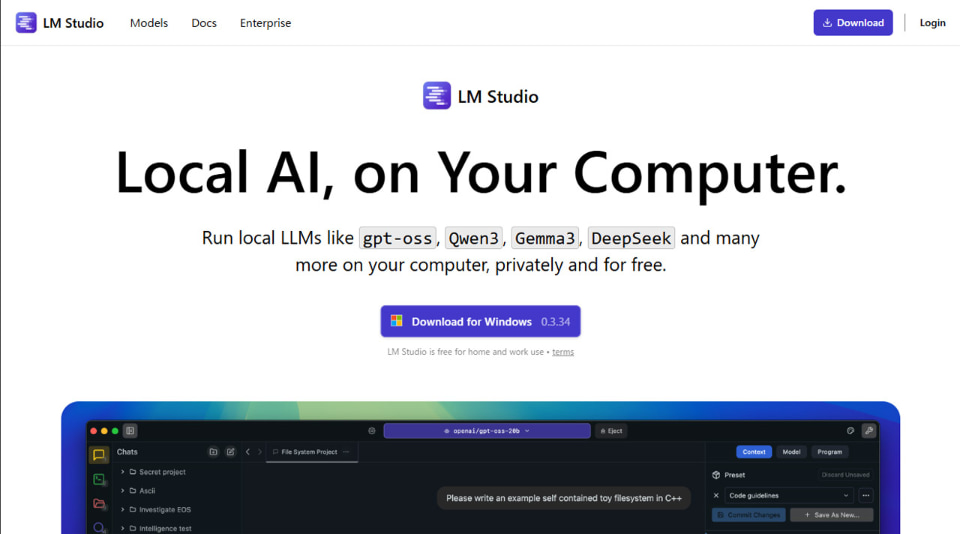

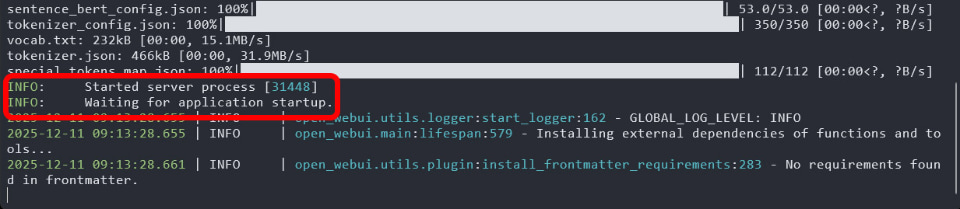

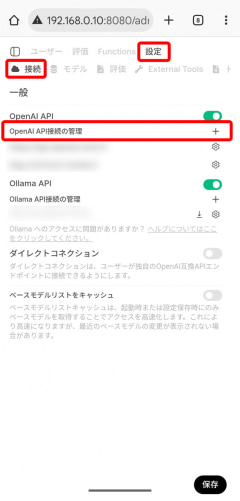

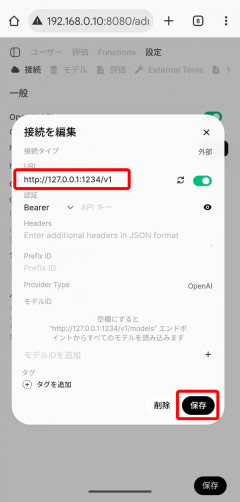

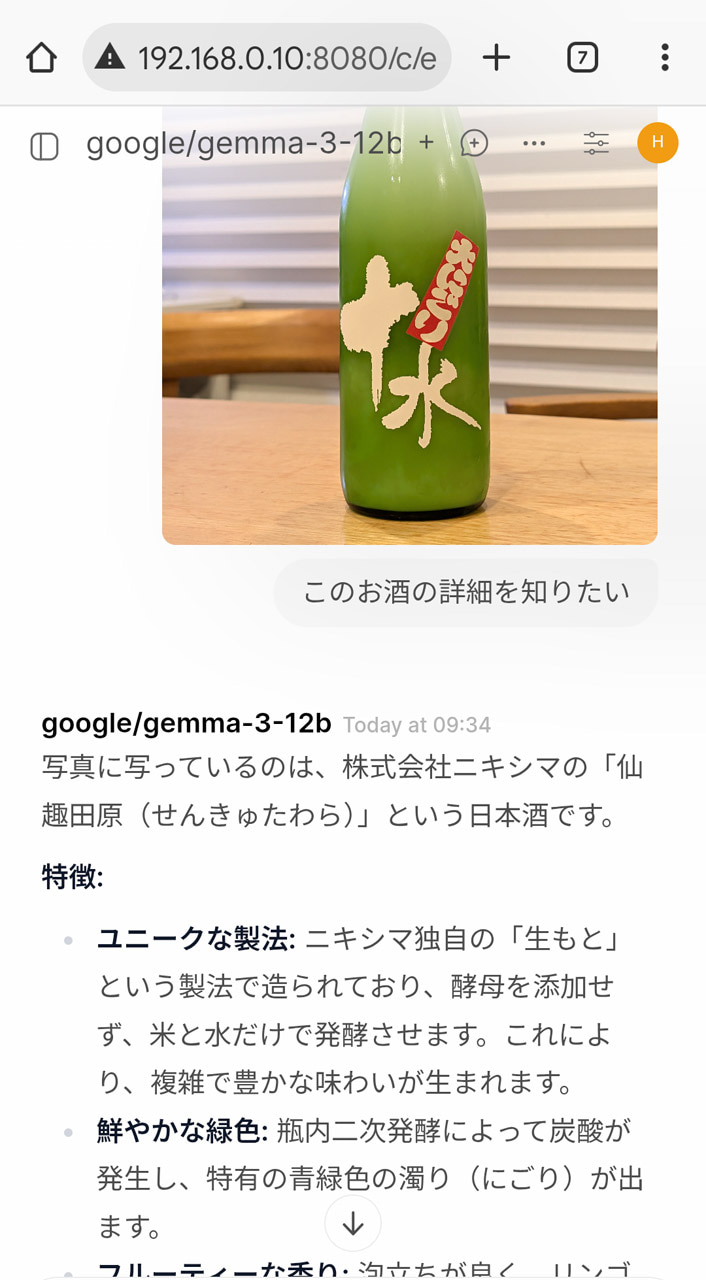

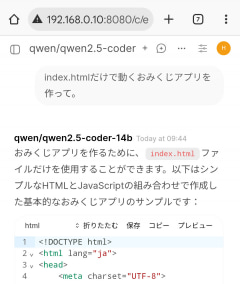

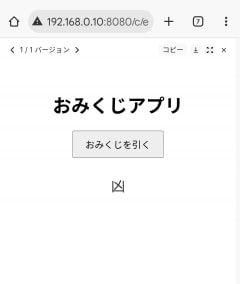

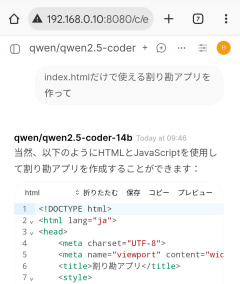

たとえばオープンなAIモデルを直接扱える「LM Studio」なるツールをパソコン上でサーバーとして動かし、「Open WebUI」というローカルAIのフロントエンドになるツールも追加して、そこにスマホからWebブラウザでアクセスするだけで、まあまあ賢いAIチャットが実現できてしまうのだ。

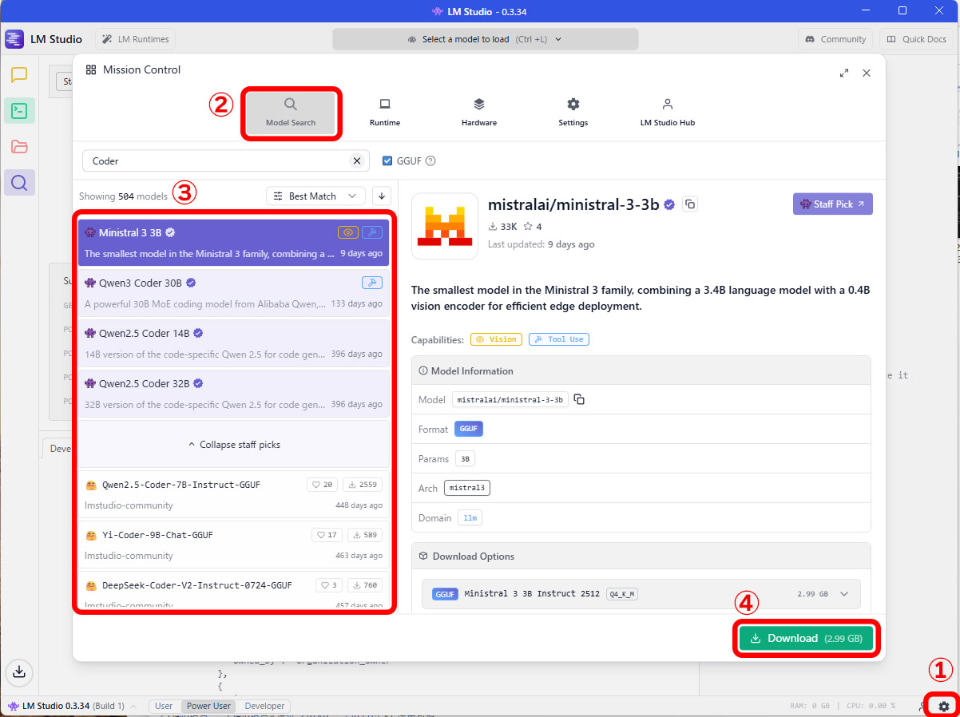

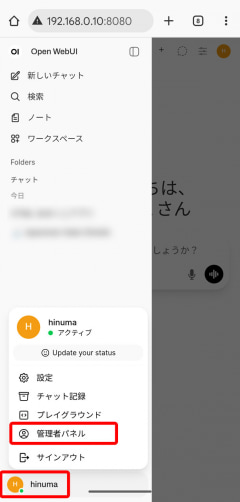

ネットの先人たちの情報を参考にした、ざっくりとしたセットアップ手順はまず、パソコンで「LM Studio」をインストール。

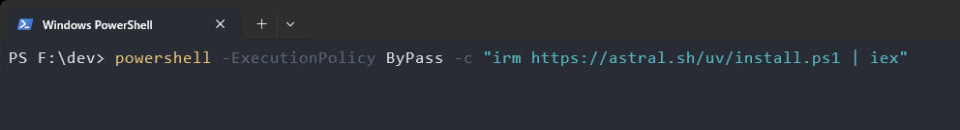

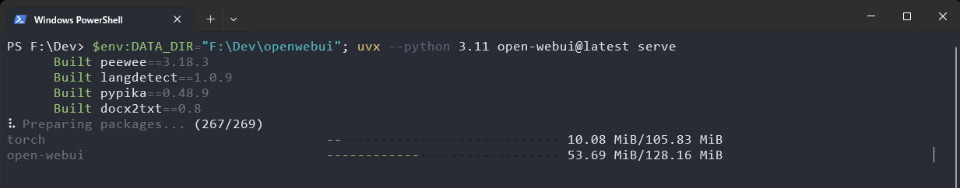

次にパソコンで「Open WebUI」を導入、設定(Pythonインストールが前提)。

ツールはどれも無料だし、AIモデルもオープンなものがよりどりみどりなので、AIさんにプロンプトをいくら投げまくってもお金は一切かからない。

いや、正確にはパソコンを動かすための電気代がかかるのでコストゼロというわけにはいかないけれども、AIの利用上限に悩まされることはないし、ヒミツのプロンプトを打ち込んだところで誰かにバレることもないので、気兼ねなくAIチャットをエンジョイできるのが素晴らしい!

あと、今回の方法だとパソコンと同じネットワーク内にいることが条件となるから、自宅外だと使えない点には注意しておきたい。外から自宅のパソコンにアクセスして利用できるようにする方法もあるけれど、そのあたりはちょっと面倒なので後回し、ってことで。

それはさておき、好き放題にいろいろ相談できるローカルAIはやっぱり気楽だ。パソコンのGPUをブン回すので電気代は覚悟しなければならないけれども、それなりのGPUならそれなりのサイズのAIモデルで、それなりに高速に賢い答えを返してくれる。

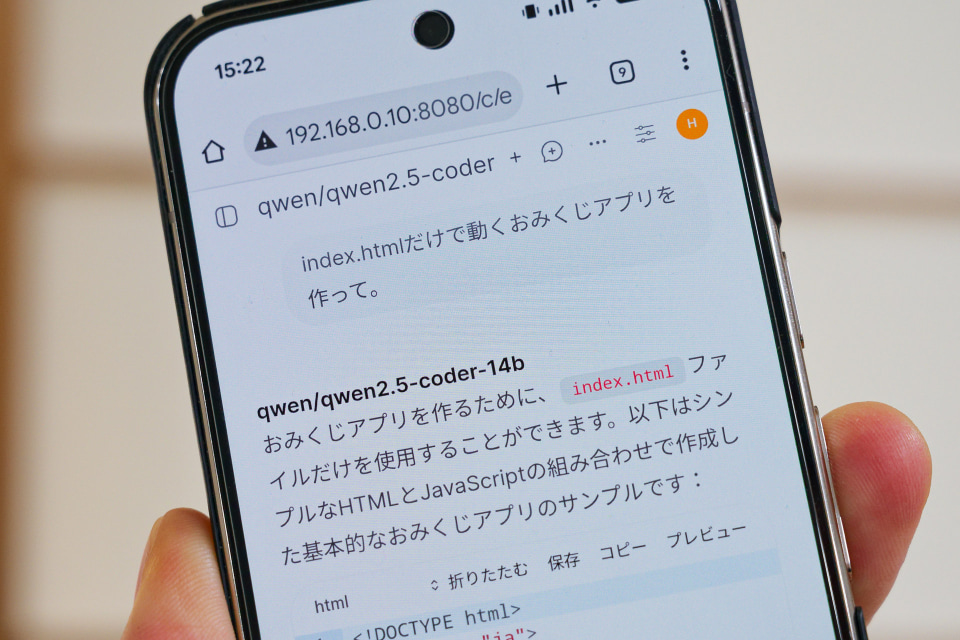

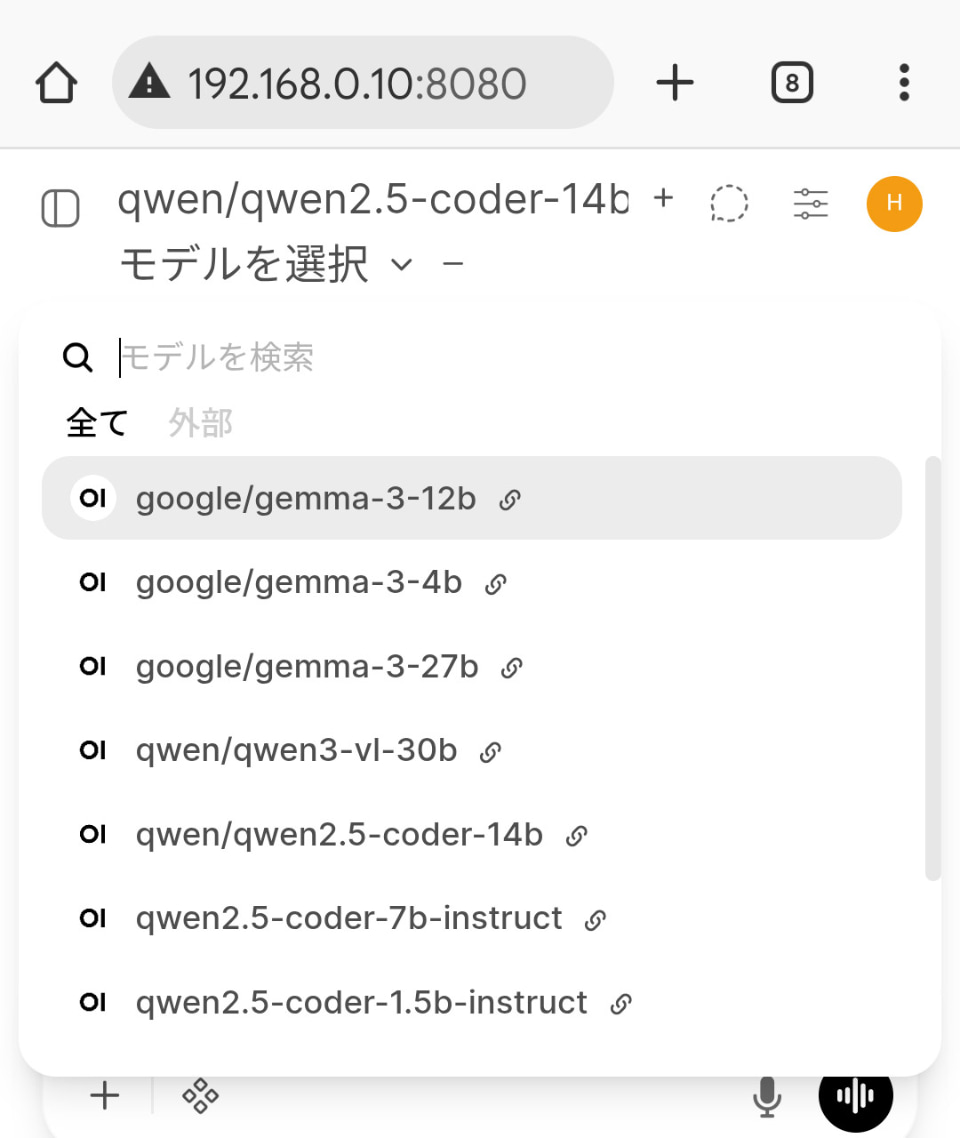

筆者の環境(Intel Core Ultra 265、メモリ64GB、NVIDIA GeForce RTX 4070 12GB)だと、たとえばプログラムコーディング向きのQwen2.5 Coder 14B(データサイズ8.37GB)がギリギリ実用範囲内だ。

もちろんこんなサイズのAIモデルは、スマホでは直接扱うなんて不可能。それが自宅にいる限りはちゃんとスマホから使えちゃうわけで、なかなかエキサイティングではないか。

でも数年後には、これくらいのAIモデルもスマホ単体で動かせる時代になるんだろうなあ、とも思う。2025年も終わりに近づいているけれども、来年もまたどれだけスマホが進化するのか、楽しみだ。