インタビュー

手話の動きを認識してテキストに、ソフトバンク「SureTalk」担当者が語る開発の想いとは

2021年8月4日 00:00

「スマホやタブレットの前で手話をするとテキストに翻訳してくれる」――そんなサービスを、ソフトバンクが電気通信大学と協力して、3月に開発した。

7月になって、iOS向けに連携するアプリも登場したそのサービス「SureTalk」は機械学習や自然言語処理といった技術が駆使されている。

今回、本誌では、開発をリードしたソフトバンクの担当者にインタビュー。耳の聴こえない人と聴こえる人とのコミュニケーションをよりスムーズにする「SureTalk」の仕組みと狙いを聞いた。

SureTalkとは

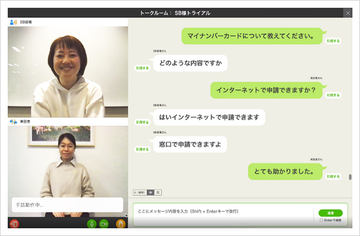

3月に発表された「SureTalk」は、カメラに向かって手話をすると、テキストに変換してくれるサービス。

技術的には、手話者の骨格から姿勢や動作といった特徴を抽出。深層学習(ディープラーニング)での認識処理により、手話を単語順に識別する。

SureTalkは、パソコンやiPadをつかい、ブラウザベースで会話を翻訳してくれる。これまでのところ、一部の自治体(市役所窓口など)で使えるという。

今回、ソフトバンクでは「SureTalk」のiOSアプリを発表。これは、手話をテキスト化する機能はないが、 「自分の手話の動き」を登録できる 機能が用意された。

つまり、iPhoneを使って、さまざまな手話の動きを登録できるようになる。これにより、AIが学べる“手話の教材”とも呼べるデータが増えることになり、さらなる精度向上につながる。なかでも、ユーザー自身の動きに対する認識精度の向上が期待されている。

データの流れ

あらためて「SureTalk」のデータ処理の流れを観てみよう。

カメラで捉えた手話の動きは最終的にテキストに変換されることになるが、その第一歩として、手話の動きに対して、まず指の先からポイントとして追跡していく。

身体の動きを追跡し、数値化することで動きの特徴を抽出されると、データベースと照合し、単語として認識される。

単語として認識されれば、そのままテキストに置き換える――だけでは、日本語としては不自然になる。そこで自然言語処理で、より自然な文章へ修正するというプロセスも用意されている。

会話するには、当然ながら耳の聞こえない人からの一方通行だけではなく、耳の聴こえる人からのメッセージも、聞こえない人へ伝える必要がある。その際には、音声認識およびテキスト化という仕組みになる。

おおまかには、「手話の認識」「音声認識」「自然言語処理」という3つのテクノロジーで構成されるのが「SureTalk」ということになる。

これらの技術は、電気通信大学と協力して開発が進められてきた。

一緒に働く仲間とのコミュニケーションを

開発をリードしたのは、ソフトバンク技術管理本部システムサービス事業統括部サービス推進部の田中敬之担当課長だ。

きっかけは8年ほど前。ソフトバンク社内にも聴覚障害を持つスタッフが在籍し、ほぼ全ての部署で一緒に業務を進めるなか、どうしてもコミュニケーションでお互いストレスを感じる場面があった、という。

田中氏

「たとえば耳の聴こえる人が3人、聞こえない人が1人という場合だと、文字起こしツールを使って伝達しようとしても、文章を読んでいる間に次の話題に移ってしまうことがある。耳の聞こえない人が何か伝えたくても、気づかれない可能性もあった」

どうしても生じがちなコミュニケーションのズレをどうにか解消できないか。よりリアルタイムに近いやり取りをする際、音声認識とテキスト化の技術はすでに開発が進められているが、聴覚障害者にとって一番使いやすいものは手話――そこで手話を認識する技術の開発に着手することになった。

こうした開発がソフトバンク社内で進められた背景のひとつとして、4~5年ほど前、同社内で開催されたビジネスアイデアコンテストがあった。そのとき、田中氏の提案による手話認識のアイデアと同じような発想を持った別のグループからの提案もあり、開発プロジェクトが発足した。

2013年~2014年ごろは、手話が言語と定義された「障害者権利条約」を日本が批准した時期でもあった。そうした状況から手話に関する技術開発が活発になった。

当時の状況について、田中氏は「いろんな大学で手話認識の研究は進められていたが、単独研究ではデータが集まらない。当時はグローブを装着し、センターを取り付けて動きを検出していた。機械学習の一歩という状況で、基礎研究は進められていたが、事業化には至っていなかった」と振り返る。

動く「手話」を認識する難しさ

ここ数年、「AI」「人工知能」とも呼ばれる技術を用いたサービスや、スマートフォンの新機能が数多く登場している。

そうした状況のなか、「手話認識」の難しさはどこにあるのか? という筆者の問いに、田中氏は「動いていることが大きな違いなんです」と率直な答え。

認識の精度を高めるには、教材とも言えるデータが必要だ。そして、静止画のデータであれば大量にあるものの、手話は「動いている」ため、軌跡をもとに推定する必要がある。動作を追跡するアルゴリズムを使い、手の動きの始まりから終わりを検知することになる。隠れマルコフモデルと呼ばれる仕組みからまず着手し、精度の向上が図られてきた。

こうした仕組み上、現在はまだ全てサーバー上で処理される。最近ではスマートフォン側でも「オンデバイスAI」と呼ばれる処理の仕組みを搭載する動きはあるが、「SureTalk」ではサーバーで駆動するほどの処理とのことで、現状はまだクラウド側で処理するかたちだが、将来的には端末側への実装も検討していく。

現在は、Wi-Fi経由での利用が想定されているが、映像を使うこと、リアルタイム性が求められることから、クライアント端末の近くで負荷の高い処理をこなすMECや、低遅延・大容量といったスペックを実現する5Gにマッチしたサービスと言えそうだ。

単語を増やし、より普段使いの存在へ

「SureTalk」では、日本語対応手話からまずサポート。単語はこれまで2000語ほど対応しており、単語ひとつに数十~100程度のサンプルデータを集めている。

2019年から始めたデータ収集はこれまで1万件ほど貯まったが、「まだ十分ではない」と田中氏。それも、全てのシーンではなく、まずは自治体での利用を想定して精度向上が図られてきた。トイレや階段、エレベーターといった汎用的な単語もあるが、役所を訪れて職員とやり取りする、といった場面にあわせている。

そこで7月下旬に登場したiOS版「SureTalk」で単語を、ユーザーの手話の動きを登録できるようにすることで、さらなるデータ拡充が期待されている。

今後はAndroid版の提供も視野にいれていると語る田中氏は、サービス自体は無料で提供されることを踏まえ「技術を駆使して、当社が社会課題を解決したい。耳の聴こえる人と、聞こえない人との間の壁をなくしたい」とその意義を説明、「皆さんと一緒に作り上げたい」と語っていた。