ニュース

Google、「Gemini 3 Flash」の新機能「Agentic Vision」を提供

2026年1月28日 19:24

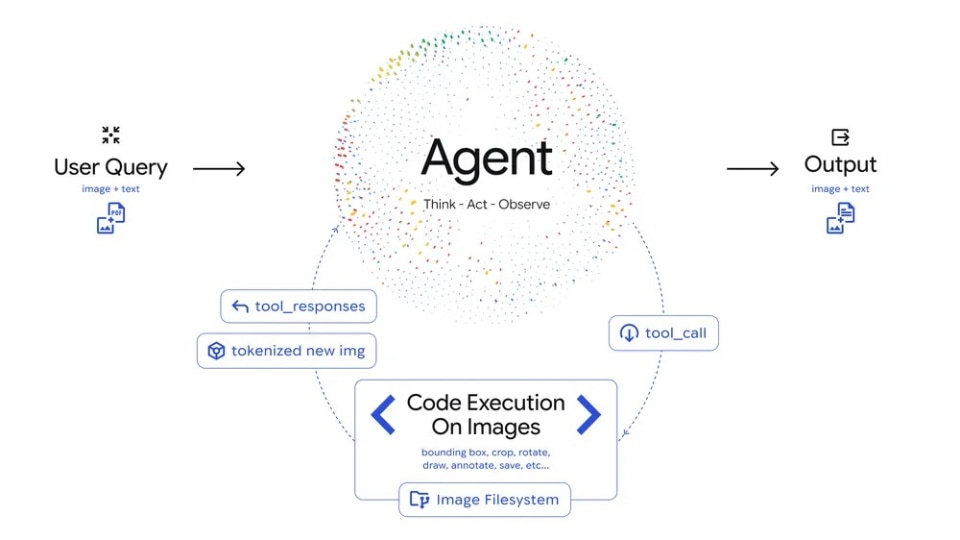

Googleは、AIモデル「Gemini 3 Flash」の新機能として、視覚情報の推論とPythonコードの実行を組み合わせた「Agentic Vision」を提供開始した。

「Agentic Vision」は、画像理解を「能動的な調査」として扱うもの。モデルは提示された画像に対し、「考える(プラン策定)」、「動く(コード生成・実行)」、「観察する(変換後の画像を確認)」というループを自律的に繰り返すことで、視覚的な証拠に基づいた回答を導き出すという。

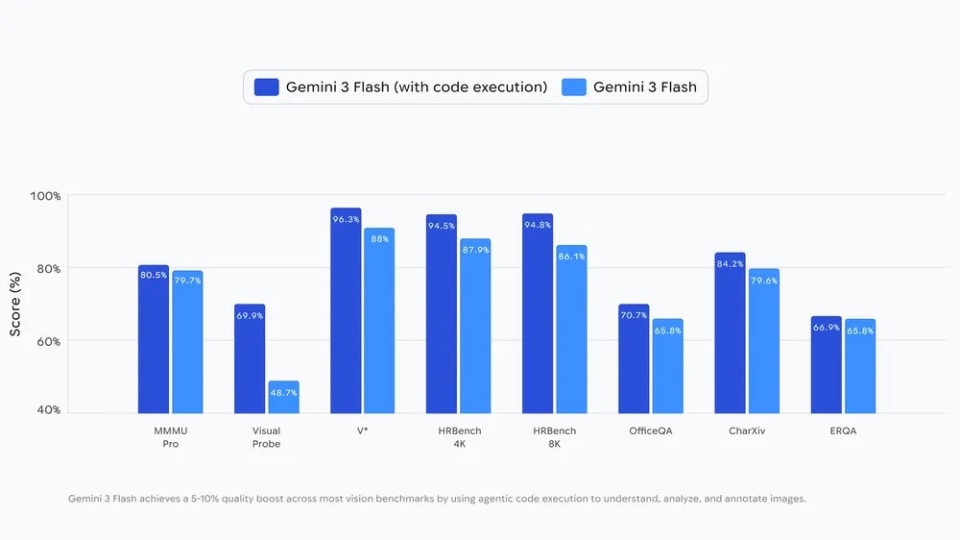

この機能により、コード実行を有効にした環境下では、ほとんどのビジョンベンチマークで5~10%の品質向上が実現するとうたう。

Agentic Visionの主な機能

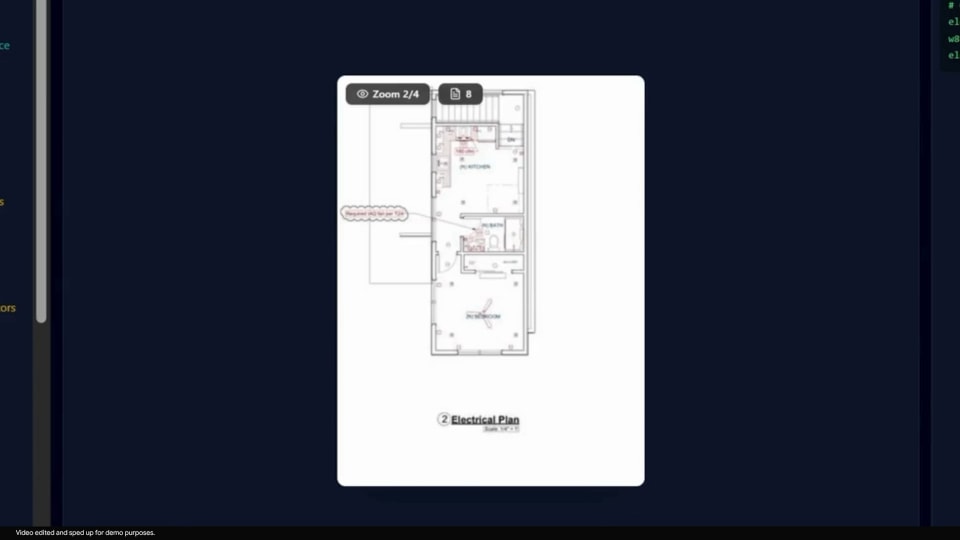

Agentic Visionの導入により主に3つの機能が利用できるようになった。1つ目の「ズームと検査」は、画像内の微細な詳細を検出する際、モデルが自律的に特定の範囲を切り取り、拡大画像として再分析するもの。

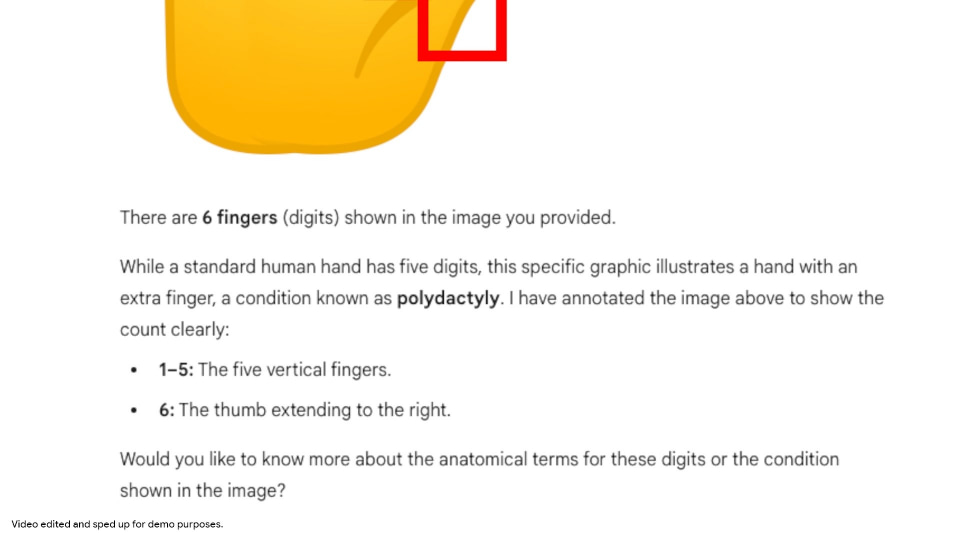

2つ目の「画像注釈」は、識別した対象に境界ボックスやラベルをPythonで直接描き込むもの。たとえば、手の指を数える際に各指に番号を振ることで、推論の根拠を視覚的に固定し、数え間違いを防ぐとのこと。

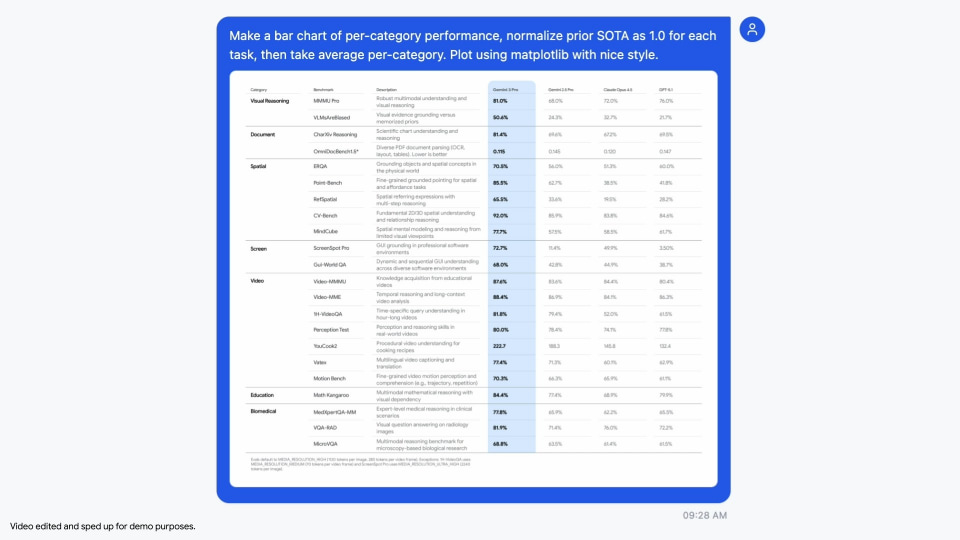

3つ目の「視覚的な計算とプロット」は、 画像内のテーブルデータを解析し、Matplotlib棒グラフを生成するもの。

同社によると、今後は画像の回転や計算といった動作もユーザーの指示なしに暗黙的に実行できるように取り組んでいるとのこと。また、Web検索や逆画像検索といったツールとの連携、Flash以外のモデルサイズへの展開も予定されている。

Agentic Visionは、Google AI StudioおよびVertex AIのGemini API経由で利用できる。Geminiアプリにおいても、モデル選択から「Thinking」を指定することで順次利用可能となる。