ニュース

Google レンズが「AR翻訳」でより自然に、検索結果の表示に大幅変化も

2022年9月29日 02:32

グーグルは、「Google アプリ」などにおいて検索時の機能を拡張する。29日から順次利用できるようになる。

AR翻訳がより自然に

「Google レンズ」などで利用できるAR翻訳(Lens AR Translate)では、翻訳された文章がより自然に見えるようになる。これまでは、翻訳後の文章はもとの画像を隠すようなかたちで表示されていたが、今後のアップデートにより元の文章がそのまま置き換わったかのような自然な表示で利用できるようになる。

「GANモデル」と呼ばれる、Pixelの「消しゴムマジック」機能でも使われるAI処理を強化して実現するもので、元の文章を消去しその部分をAIが生成した背景に置き換え、その上に翻訳後の文章を表示する。

これにより本来、その画像が意図したように情報を得られるとしており、2022年後半にも利用できるようになる。

iOS版のGoogle アプリがより使いやすく

また、iOS版のGoogle アプリでは、検索画面にショートカットを配置する。スクリーンショットの取得やカメラを使っての検索、音声での検索といった機能が用意され、9月29日から順次利用できるようになる。

検索結果の見た目も大幅変更に

このほか、検索がよりスムーズになる機能も用意される。テキストでの検索時には、入力した内容に応じて適切なキーワードが選択できるようになる。メキシコについて検索した際には「家族旅行に適した街」というように、関連性が高い情報を簡単に得られる。

加えて、行ったことがない都市がどのような場所か、その情報について詳しいクリエイターによるコンテンツなどが表示される機能も合わせて用意される。これにより情報を直感的な方法で整理できるとしている。

また、検索ワードについてより深く掘り下げるワードを合理化しワードの追加や削除も可能になるという。

さらに、検索結果の表示形式の種類を増加させる。さまざまなフォーマットの情報でも多くのソースからもっとも関連性の高いコンテンツが表示されるとしており、これまでのように検索結果の下位にあるほど、関連性が低いといった印象を打ち消し、スクロールを続けてもランキングの結果にさまざまな選択肢を加えるという。

こうした機能は今後数カ月以内に米国で提供されるとしている。

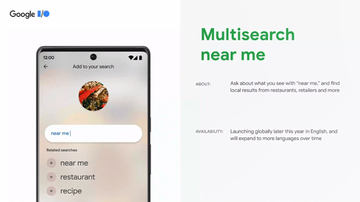

加えて、マルチ検索では今後数カ月以内に70以上の言語に対応するほか、マルチ検索とユーザーの位置情報を組み合わせる「Multisearch near me」は今秋にも米国で提供が開始される。同社ではカメラで撮影し、言葉を添えて検索するマルチ検索(Multi Search)が検索したいものをより簡単に探せることから「カメラが次のキーボードのようになる」としている。